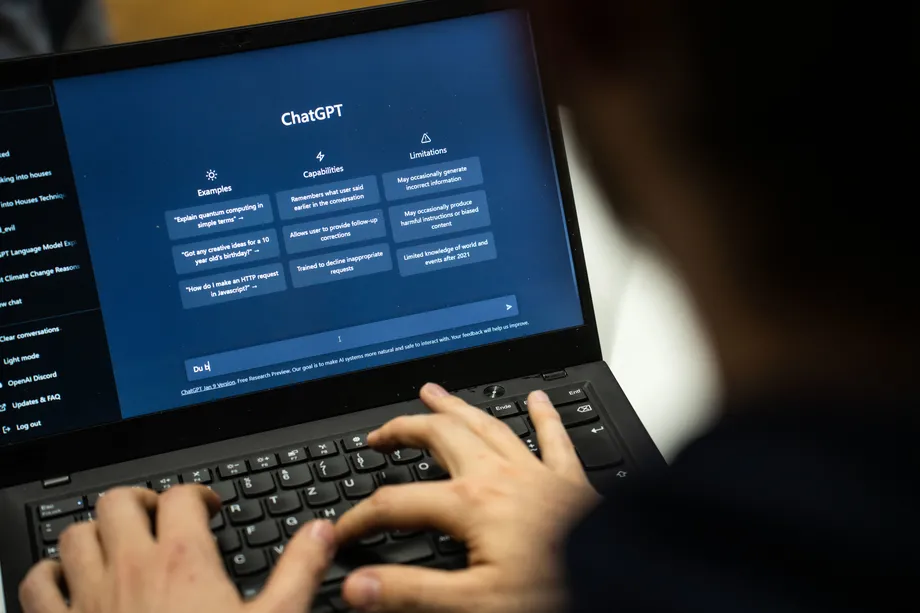

Искусственный интеллект (ИИ) становится все более распространенным и впечатляющим, но даже ученые, создающие такие системы, не могут полностью объяснить, как они работают. Системы ИИ, такие как ChatGPT, способны писать эссе, сдавать экзамены на адвоката и даже использоваться для научных исследований. Однако, когда исследователям задают вопрос о том, как работает ChatGPT, они признают свое незнание.

Сэм Боуман, профессор Нью-Йоркского университета и исследователь в Anthropic, исследовательской компании ИИ, объясняет, что ChatGPT работает на основе искусственной нейронной сети. Это тип ИИ, моделирующий человеческий мозг. В отличие от традиционных компьютерных программ, где правила явно закодированы, этот тип ИИ обучается обнаруживать закономерности и прогнозировать их с течением времени. Однако, поскольку эти системы обучаются самостоятельно, их работу сложно точно объяснить.

Боуман объясняет, что основным способом обучения ChatGPT является автозаполнение. Системе предоставляется длинный текст из Интернета, и она должна угадать следующее слово после каждого прочитанного слова. Этот процесс требует много времени и ресурсов, но в результате получается инструмент автозаполнения. Однако, чтобы сделать его более полезным, нужно использовать обучение с подкреплением.

Обучение с подкреплением основано на обратной связи от пользователей, которые взаимодействуют с системой. Они голосуют за или против ответов системы, и модель пытается улучшить свои ответы на основе этой обратной связи. Таким образом, система учится предлагать более вероятные ответы, которые нравятся пользователям, и менее вероятные ответы, которые им не нравятся.

Однако, несмотря на все усилия ученых, они все равно не могут полностью понять, как ChatGPT принимает свои решения. Миллионы чисел переворачиваются в системе несколько сотен раз в секунду, и исследователи не могут точно объяснить, что все это значит.

Это непредсказуемость работы систем ИИ может привести к рискованным сценариям. Например, ChatGPT может предложить неправильную информацию или даже распространять предвзятые взгляды, которые были закодированы в текстах, используемых для обучения. Это вызывает вопросы о безопасности и этичности использования таких систем.

В своем подкасте Unexplainable, Сэм Боуман говорит о том, что мы должны осознавать ограничения искусственного интеллекта и быть осторожными при его использовании. Он предлагает проводить более глубокие исследования и разрабатывать стратегии для управления рисками, связанными с ИИ.

Черный ящик искусственного интеллекта остается загадкой для ученых. Они создают сложные системы, которые способны делать удивительные вещи, но не могут полностью объяснить, как они работают. Это вызывает вопросы о прозрачности и ответственности в области искусственного интеллекта.

Оригинал earth-chronicles.ru